最近,#广州地铁#登上热搜;起因是一女子在地铁上的裸体照片被疯传。但事实上,这张裸体照并非真实照片而是被AI一键脱衣生成的……据泾渭视频报道:近日,广东广州,一女子在地铁上的照片被AI一键脱衣,造谣图在网络广泛传播引发关注。事实上,照片的女主角是小红书的一名博主,而所谓的“裸照”则是她去年7月在平台分享的一张照片。原图中她衣着正常,完全没有任何不妥之处,但却被有心之人用AI软件一键脱衣,故意全网散播。目前博主称会进行相关的维权处理。

早在2019年,国外程序员就开发出了DeepNude这款使用AI技术“脱衣”的应用,通过使用类似deepfakes的深度学习技术,DeepNude使用女性裸照训练之后可将图像中女性身上的衣服替换掉,创造出几可乱真的合成裸照,也就是大家所说的“一键脱衣”。后因广泛的舆论争议,开发团队选择将该项目关闭。但记者发现在网站搜索“AI脱衣软件”仍然会出现众多“替代品”。

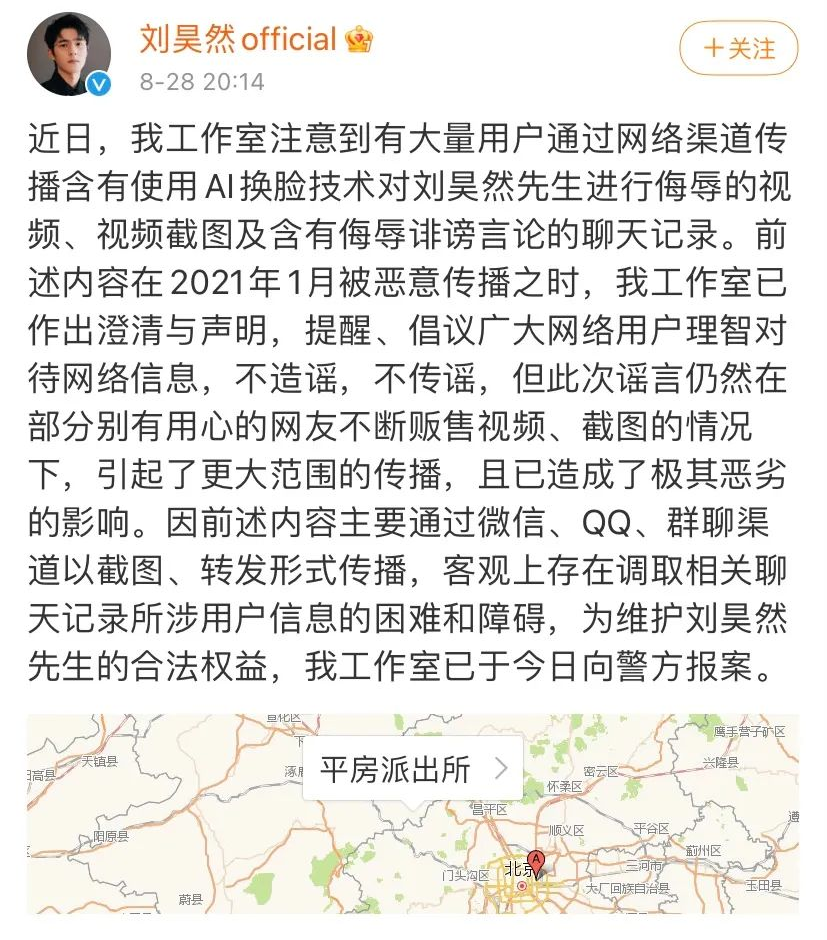

近年来,“AI换脸”走红网络,一些“AI换脸”的App使用明星的图片制作换脸视频进行推广,其趣味性背后暗藏不少法律风险和侵权纠纷。而早在2021年8月26日,明星刘昊然也曾发博打假,控诉网上流传的某淫秽视频为AI换脸技术伪造,并向警方报案。

4月1日,据央视网消息,最近美国和加拿大各地使用AI合成语音进行电信诈骗的案例多发,不少上当的都是老年人。人工智能语音一直受到业界关注,如今该技术已经发展到需要几秒钟的对话就足以准确模仿某人声音的程度。加拿大警方称,最近加拿大各地都有不少类似案件发生,涉案金额已达数百万加元。有受害者表示,犯罪分子使用的声音和她儿子的声音简直一模一样。在美国,类似的诈骗案件近期也呈上升趋势。美国联邦贸易委员会公布的数据显示,电信诈骗是美国最常见的诈骗形式,2022年相关涉案金额已达26亿美元,其中很多案件都借助了AI技术。

这些袭击似乎主要针对老年人,这并不奇怪,因为在涉及金融诈骗时,老年人是最脆弱的群体之一。

专家表示,在《网络安全法》第二十七条的规定当中,特别强调,明知他人实施危害网络安全活动的,不能够为他提供技术支持,如果情节严重,还会构成帮助信息网络犯罪活动罪等刑事犯罪。

凡此种种,无不在触及法律底线,挑战公序良俗。虽然人们很多时候会觉得“AI换脸”只是“好玩儿”,殊不知,在无意识中,已经涉及侵权,甚至违法犯罪。比如,滥用“AI换脸”技术可能会涉及侵犯他人肖像权、名誉权、著作权、个人信息等多项权利。如果随意使用一些公众人物的肖像进行“AI换脸”,不但构成侵权,还可能危害公共秩序。此外,散播利用AI技术伪造的“裸照”,造谣者对公民权利和社会秩序造成严重侵害,违反了《中华人民共和国治安管理处罚法》。根据《中华人民共和国刑法》相关规定,若造谣者将制作的淫秽信息上传至第三方平台,进行传播并以此牟利的,涉嫌制作、传播淫秽物品牟利罪。